阿里巴巴开源自主搜索 AI 智能体 WebAgent

WebAgent 不仅能识别文献中的关键信息,还能通过多步推理将不同文献中的观点进行整合,最终为用户提供一份全面且精准的研究报告。

IT之家,2025-05-30 06:40:47

5 月 30 日消息,阿里巴巴昨日在 Github 上开源了其创新的自主搜索 AI Agent——WebAgent,具备端到端的自主信息检索与多步推理能力,能够像人类一样在网络环境中主动感知、决策和行动。

例如,当用户想了解某个特定领域的最新研究成果时,WebAgent 能够主动搜索多个学术数据库,筛选出最相关的文献,并根据用户的需求进行深入分析和总结。

据介绍,WebAgent 不仅能识别文献中的关键信息,还能通过多步推理将不同文献中的观点进行整合,最终为用户提供一份全面且精准的研究报告。

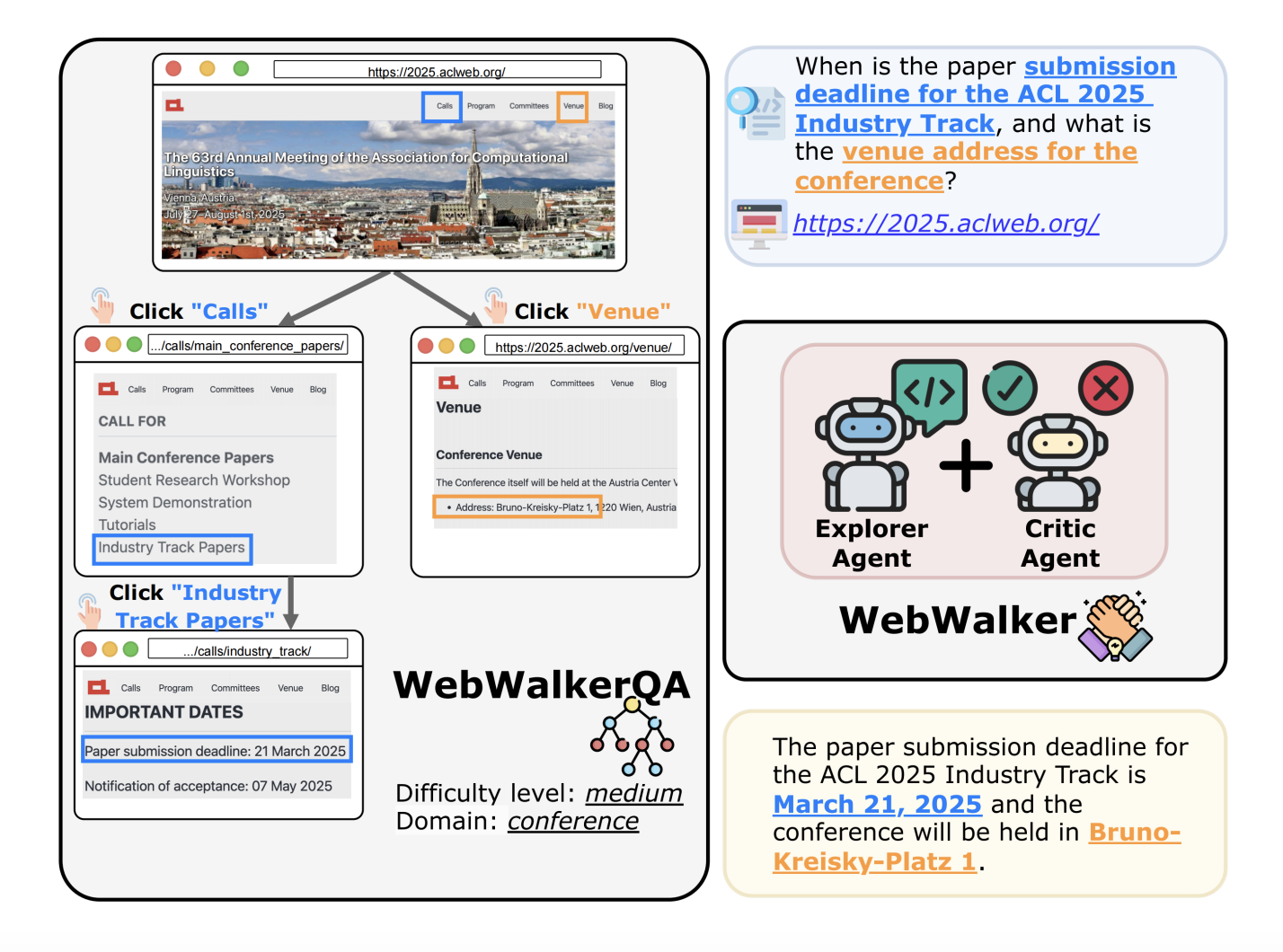

阿里巴巴 WebAgent 分为 WebDancer 和 WebWalker,前者是一种端到端智能体训练框架,旨在增强基于网络的 AI 智能体的多步骤信息搜索能力;后者则属于“Web 遍历中的 LLM 基准测试”。

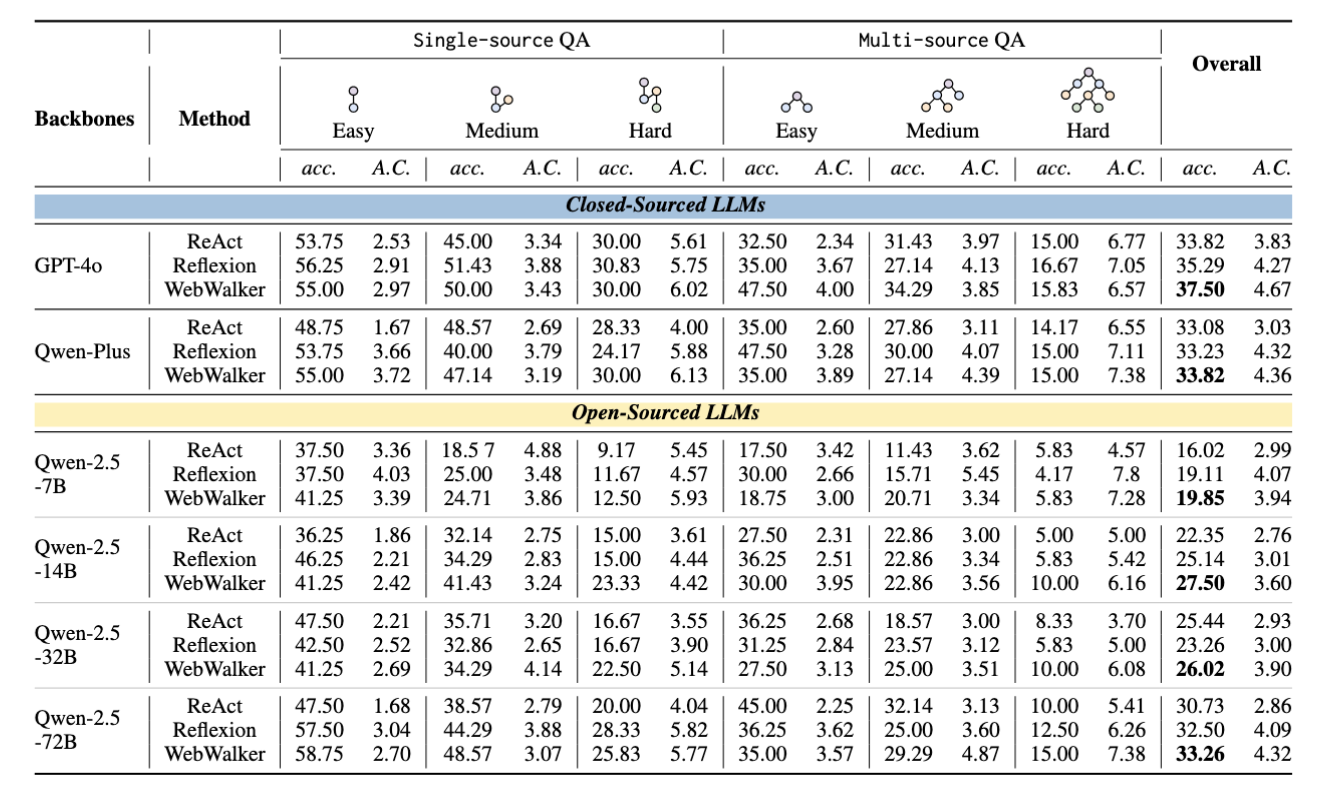

Web Agents 上的性能:

WebDancer 的框架一共由 4 大块组成,从数据构建到训练优化,逐步打造出能够自主完成复杂信息检索任务的智能体。

浏览数据构建是整个框架的起点。在现实世界中,高质量的训练数据是智能体能够有效学习和泛化的关键。WebDancer 通过两种创新的数据合成方法来解决传统数据集的局限性。

为了确保生成的轨迹既有效又连贯,WebDancer 采用了短推理和长推理两种方法。短推理利用大模型直接生成简洁的推理路径,而长推理则通过推理模型逐步构建复杂的推理过程。

在数据准备完成后,WebDancer 进入监督微调(SFT)阶段。这一阶段的目标是通过高质量的轨迹数据对智能体进行初始化训练,使其能够适应信息检索任务的格式和环境要求。

在 SFT 过程中,WebDancer 将轨迹中的思考、行动和观察内容分别标记,并计算损失函数,以优化模型的参数。为了提高模型的鲁棒性,WebDancer 在计算损失时排除了外部反馈的影响,确保模型能够专注于自主决策过程。这一阶段的训练为智能体提供了强大的初始能力,使其能够在后续的强化学习阶段更好地适应复杂的任务环境。

强化学习(RL)阶段是 WebDancer 框架的关键环节。在这一阶段,智能体通过与环境的交互,学习如何在复杂的任务中做出最优决策。WebDancer 采用了 DAPO 算法,这是一种专门针对智能体训练设计的强化学习算法。

DAPO 算法通过动态采样机制,有效利用未充分利用的 QA 对,提高数据效率和策略的鲁棒性。在 RL 过程中,智能体通过多次尝试和反馈,逐步优化其决策策略,最终实现高效的多步推理和信息检索能力。

附 WebAgent 官方地址: